怎么看待职场中的“业务壁垒”?

在我的工作中,曾经发生过这样一件事:有一天我们在讨论,能不能实现一个业务通用组件,让各个业务接入,提升业务需求的开发效率等,这时候有一个同事就跟我说:‘那如果真的实现的话,那你这边的业务就啥都没了’,言外之意就是我这边“没事做了”。我给他的回答是:‘没关系,只要是有意义,有价值,对公司是正确的就行’

那么?我真的那么爱公司吗?

- 当然不是,我只是觉得应该做自己认为正确的事,顺便说一下漂亮话忽悠一下。

在工作中,你们到遇到很多“业务壁垒”。通俗来讲,这个东西只有他会,或者短期内只有他能搞定。你甚至会觉得一股恶心,就是很乱很难受,并惊叹对方的忍耐力。

然而,无数的事实证明了,这个世界不会因为没有谁就不行。

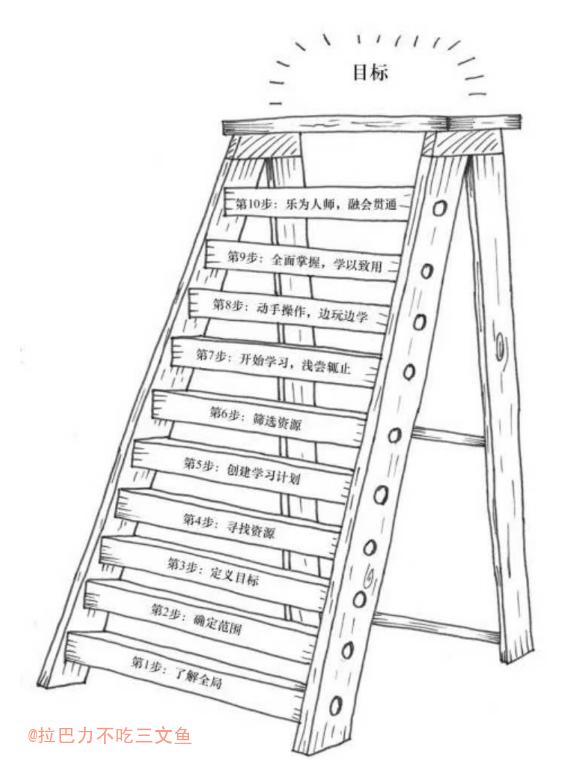

而我的原则是:做正确的事,不制造业务壁垒;保持出色的整理学习能力,输出业务文档,让自己随时可替换,甚至寻找可以替换自己的人;不做狭义对自己有利的事,尽量做广义对公司有利的事。

具体来说,可以这样阐述

- “业务壁垒”不是我认同的核心竞争力,甚至混乱的“业务壁垒”不是我能忍受的工作体验;

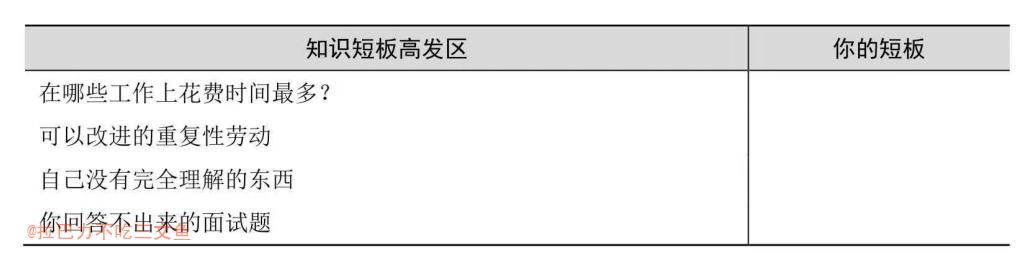

- 出色的整理学习能力,坚信长期主义,才是我认同的核心竞争力;

- 我在提升自己可替代性的同时,也是在提升自己的“不可替代性”;而有些地方,并不需要“不可替代性”的人;

- 提升自己可替代性,其实也是在保持业务的稳定;不会因个人而大受影响,甚至我因此可以放心度假,因为我会的东西,别人也可以快速学会和处理;

关于“可替代性”另外补充:

- 增加自己的安全感(休假可以找到别人)

- 增加别人(比如上级)的安全感(万一找不到,出意外有其他人解决)

- 个人清高,一定程度上,喜欢更高维度的不可替代性